(contenido creado a finales de 2025, no sé lo bien o mal que envejecerá este post)

Con frecuencia, mis colegas investigadores me preguntan sobre qué plataforma de IA les recomiendo que pueda dar buenas respuestas a preguntas científicas/profesionales. Me ponen por ejemplo que los profesionales de medicina usan cosas como OpenEvidence ; Search – Consensus: AI Search Engine for Research ; Elicit: AI for scientific research …

Mi opinión en estos momentos, basada en los experimentos que llevo haciendo desde hace un par de años (experimentos informales, no del todo sistemáticos, y sobre todo centrados en los temas o asuntos que me interesan a mí en mi día a día como investigador, docente y consultor), es que no hay nada en nuestro campo que aporte resultados “decentes” (que sean útiles, ciertos o que no tengan un sesgo tremendo en la respuesta).

Tanto OpenEvidence como Consensus, Elicit y similares solo aciertan (cuando aciertan) con literatura de ciencias de la salud.

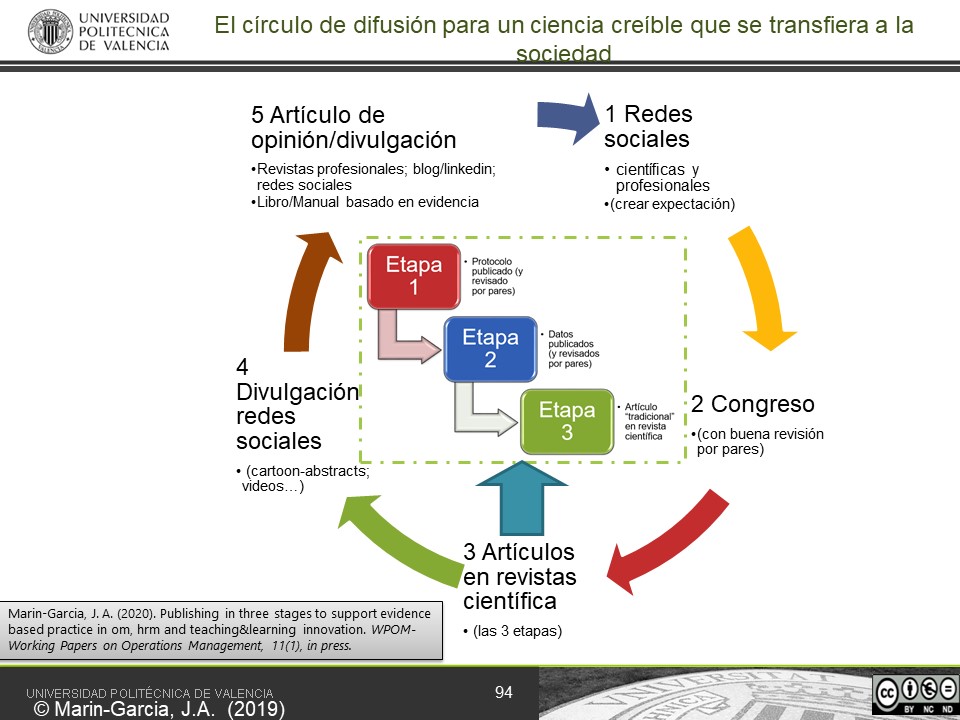

Los motivos son claros para mí. Primero el modo que esas comunidades difunden su ciencia:

-

- El tipo de artículos e investigaciones que hacen

- Lo específicos que son al emplear términos y la estricta nomenclatura que usan (nunca emplean el término “dolor de cabeza”, usan, por ejemplo, cefalea tensional, neuralgia o migraña…, y cada uno es diferente de los otros)

- El consenso en la reutilización de instrumentos de medida que se han demostrado válidos y fiables

- y la tradición en “medicina basada en evidencia” que tienen (que igual es el origen de todo lo anterior)

Eso les permite que la IA pueda sacar resultados interesantes.

Además, aunque ya más tangencialmente, el conjunto de documentos con el que se ha entrenado el modelo (que claramente está sesgado a esas ciencias, porque entiendo que es donde más negocio pueden hacer los que venden esas plataformas).

Sin embargo, en el caótico mundo de la investigación en Management, donde cada uno pone el nombre que le da la gana a las “cosas” y midiéndolo cada vez de una forma distinta, el resultado es que una misma palabra significa cosas distintas en distintos artículos (homonimia) y, al mismo tiempo, las mismas cosas se nombran con palabras completamente diferentes (sinonimia).

No sé si resolviendo esto resolveríamos completamente el problema, pero habríamos dado un paso de gigantes para poder hacer una extracción sistemática a gran escala del enorme conocimiento que se ha ido generando en el área y que, de momento, está enmarañado.

Visitas: 23